日本企業に求められるAI利活用におけるガバナンス構築

- 関連キーワード:

AI(人工知能)の進化と普及は、社会全体に新たな機会をもたらしています。しかしその一方で、AIがもたらす社会的な影響や倫理的な問題についての議論も深まっています。特に、2023年からの生成AI(Generative AI)の急速な普及を契機に、AIに係るリスクも改めて注目を浴びています。

同時に、現在AIの利活用に関する規制やガイドラインの整備が各国で進められています。しかし、その規制内容や取り組みは国や地域によって異なるため、企業がどのように対応すべきか一概に言えるものではありません。AI利活用を推進する企業は、並行してそれに伴うリスクを把握し、各国の法規制や各種ガイドラインの動向を踏まえたうえで、幅広いリスクに対応することが求められます。

本コラムでは、AI利活用に伴うリスクをどのように捉え、今からどのように準備しておくべきかについて、富士通のAI倫理ガバナンス室長の荒堀淳一氏と、日本企業のAIガバナンス構築を支援するRidgelinezの藤本健との対談形式でお伝えします。

AI利活用に伴うリスクとは何か

――ここ数年のAIの発展には目覚ましいものがあり、特に2023年はChatGPTをはじめとする生成AIが急速に普及し、個人・企業・政府において様々な活用が進められていますね。

藤本 昨今のAI技術の革新は私たちの生活・ビジネスに大きな影響をもたらしており、特に生成AIはビジネスの変革を加速させる可能性を秘めていると感じています。個人の生産性を高めるだけでなく、業務の簡素化などのプロセス変革から、将来的には人員の再配置などの組織変革をもたらすことまで期待され、多くの企業の様々なシーンで利活用の検討が進められています。当社にも、お客様から様々な業務におけるAI利活用の検討に関するお問い合わせが増えています。

荒堀 AIは、社会発展において重要な役割を担う一方で、その技術的な特性から人が予期せぬ不都合が生じるリスクも孕んでいます。多くの日本企業においてAI利活用が十分に進展していない状況下では、それに伴うリスクもさほど大きなものではありませんでした。しかし、ChatGPTのような生成AIが普及したことによって、AI利活用の幅は大きく広がりました。加えて、従業員が個人でAIを利活用できるようになり、リスクの発現可能性は急速に高まっています。

藤本 AI利活用の推進を急ピッチで進める企業が増えている一方で、そのリスクに対する検討を進めている企業はまだ多くはないと感じています。AIリスクを懸念して、AI利活用に慎重になっている大手企業もいまだに多く見受けられます。

――AI利活用に伴うリスクにはどのようなものがあるのでしょうか?

藤本 2023年1月に米国商務省の国立標準技術研究所(NIST)が発表したAI技術のリスク管理のためのガイダンス「AIリスクマネジメントフレームワーク(以下、「AI RMF」)」を参照しながらお話しします(*1)。「AI RMF」では、信頼できるAIシステムの特徴とAIが個人や組織、社会へネガティブな影響をもたらすリスク、そのリスクを回避するための実務が記載されています。

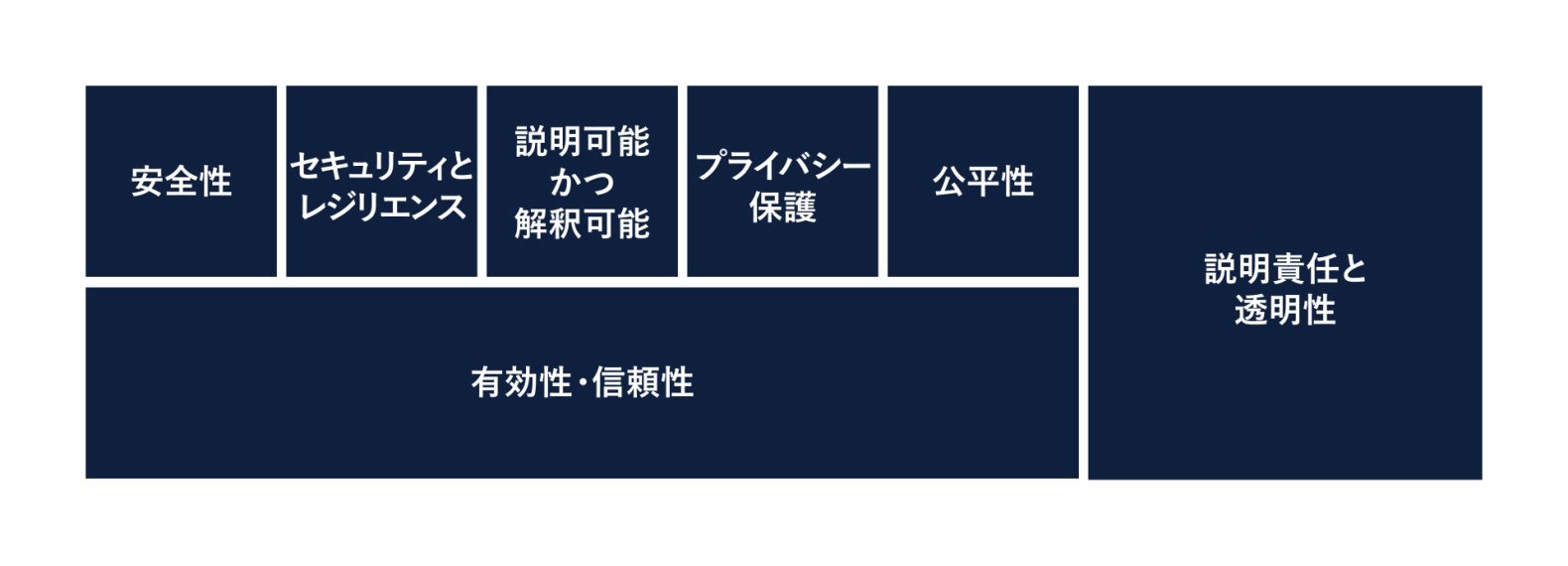

信頼できるAIシステムには7つの特徴があるとされています(図1)。まず挙げられる特徴としては、「有効性・信頼性」です。AIの性能はモデル設計や学習データの質や量に大きく依存するため、その内容により期待したパフォーマンスに達しない可能性があります。また、AIは完全ではないため、モデル設計や学習データが適切だったとしても、意図しない動作や誤った判断をするおそれがあるのです。次に、「安全性」が挙げられています。例えば、私たちの身近で考えられる自動運転や手術支援などでも、AIの判断結果が人間の生命、健康、財産、環境を危険にさらすリスクが考えられます。

(出所:National Institute of Standards and Technology資料に基づきRDL作成)

藤本 また、「セキュリティとレジリエンス」も挙げられている特徴の1つです。AIシステムやサービスについて適切なセキュリティ対策をとっていなかった場合、サイバー攻撃によってAIの悪用や情報盗難などのおそれがあります。外部からの攻撃や予期しない事象が発生した場合でも、通常の状態に回復する力としてのレジリエンスが求められるでしょう。

荒堀 「説明責任と透明性」も、信頼されるAIシステムには必要です。説明責任を果たすための前提として「透明性」が挙げられています。「透明性」とは、AIシステムの利用者の役割や知識に合わせて、適切なレベルの情報へのアクセスが提供されることを意味します。

藤本 その「透明性」は「説明可能かつ解釈可能」という特徴にもつながっています。AIは複雑なアルゴリズムに基づいて判断しますが、そのプロセスはブラックボックスになりがちであり、AIの判断がどのように導き出されたかを説明するのは困難となるおそれがあります。そのため、AIシステムのメカニズムを言語化でき、アウトプットを解釈できる状態がAIシステムには求められます。

荒堀 「プライバシー保護」についても慎重に考える必要があります。例えば、個人的な情報は学習データにも含まれる可能性があり、そうした場面でもプライバシーが適切に保護されているか、また、プロファイリングにおいては無意識に差別や人権侵害を行っていないかどうかを確実にチェックすることが重要です。

また、「公平性」にも配慮しなければなりません。例えば、AIの利活用に際し、もととなる学習データに偏りや誤った情報が含まれると、そこから出力されるアウトプットにも、そのデータに潜む社会の不公平・不平等が反映される可能性があります。その場合、AIが性別や国籍、人種といった特定のグループに対して不公平な出力結果を生むリスクがあります。

――AI利活用には様々なリスクが伴うことが分かりましたが、企業はどのようにリスク対策をすべきでしょうか?

藤本 企業において適切にAIが利活用されるためには、ガバナンスの仕組みとその運用の定着化が必要です。AIガバナンスの構築を欠くと、組織として統制されていない、いわゆる「野良AI」が増えたり、法規制に準拠していない、もしくは倫理的に問題のある製品・サービスを市場に提供したりすることになり、企業にとってあらゆる観点で脆弱性を残したままビジネス活動を進めることになります。そして、リスクが顕在化した際には、お客様や取引先、社会などあらゆるステークホルダーの信頼を損ねることになり、自社ブランド価値の毀損・レピュテーションの大幅な低下につながりかねません。

ビジネス変革において生成AIの利活用は避けては通れないと考えます。規制強化も進んでいる中、AIガバナンス体制を構築し、安心安全なAI利活用の推進環境をつくることは、企業のAI戦略にとって重要な要素の1つであり、ビジネスにおいても自社の強みとなることは間違いないでしょう。

荒堀 AIの国際的な規制(案)の中には厳罰を伴うものも確認されています。その中の1つであるEUのAI規制法案は2023年6月に採択されたもので、これは日本企業にも関わるものですが、それに対する関心度が高い企業はまだ多くないように感じています。GDPR(EU一般データ保護規則)の制定から施行の時期を思い返すと、2016年に制定されてから2018年に施行されるまでの間、様々なセミナー等で「域外適用があり日本企業にも影響があるもの」という情報は発信されていましたが、施行直前に対応を開始する企業も少なくありませんでした。今回のAI規制法案についても、EU域内でAIシステムやサービスを提供する場合等は日本企業にも適用があるため、対応が求められる企業は決して少ないわけではなく、施行前である現在から順次対応を進めていく必要があると考えています。

国際的なAI規制の動向

――EUのAI規制法案について、もう少し詳しく教えてください。具体的にどのような規制や罰則があるのでしょうか?

藤本 EUのAI規制法案では、AIシステムのリスクを「許容できないリスク」「ハイリスク」「限定的なリスク」「最小リスク」の4つのレベルに分類しています。「許容できないリスク」を持つAIシステムは利活用を禁止、「ハイリスク」なAIシステムにはリスクマネジメントや透明性・情報提供等の要件が求められるほか、AI提供者には事前に適合性評価を受けることなども義務付けられます。違反した場合の罰金額は大きく、最大で3,500万ユーロまたは前年度の全世界売上高の7%のいずれか高い方で課されることになるのです。

荒堀 「ハイリスク」なAIシステムやその提供者に対しては、事前の適合性評価に加え、リスクマネジメントや品質マネジメントの仕組みの構築とその監視が求められており、EUのAI規制法案は透明性や安全性の確保を重要視していると考えられます。この法案は2023年12月に大筋で合意され、2026年には施行される見通しであり、日本企業にとっても対応を先延ばしにすべきではないと認識しています。

――日本でもAIに関する規制やガイドラインは制定されているのでしょうか?

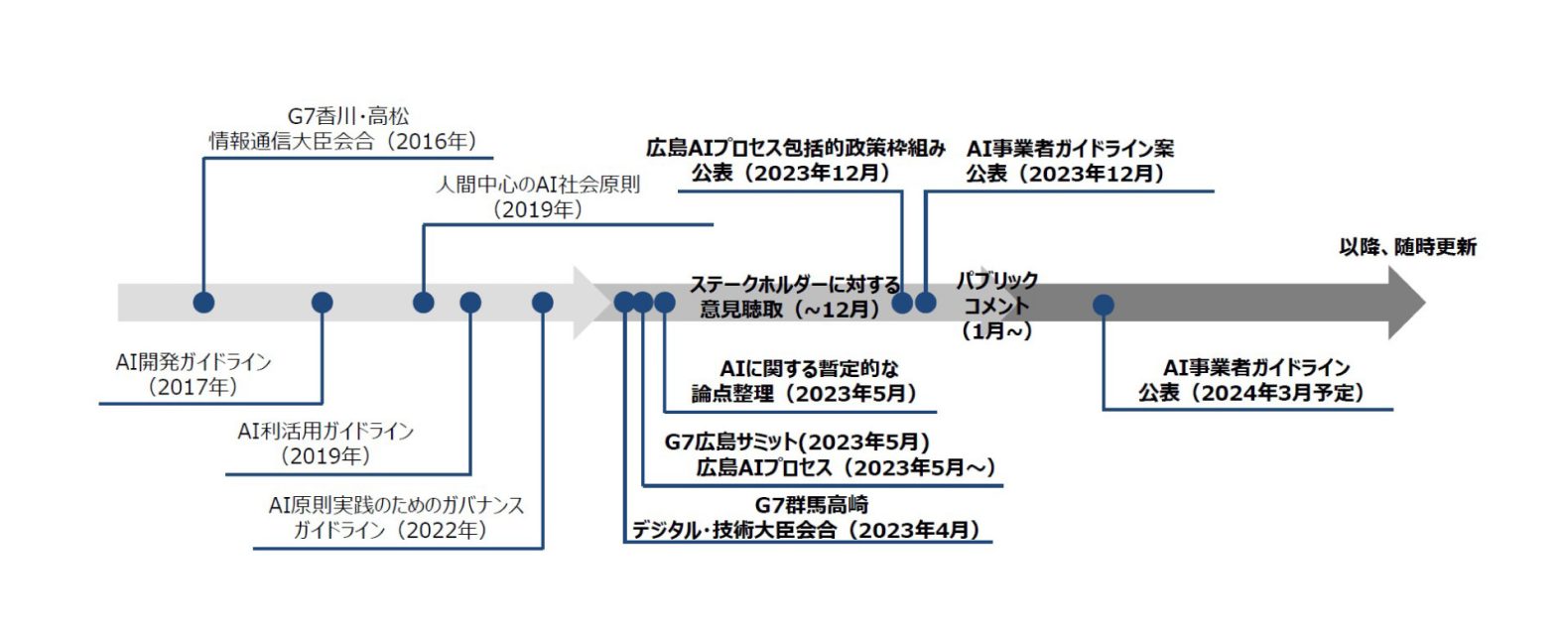

藤本 日本でも原則やガイドラインが公表されています。2019年に政府統一の原則として「人間中心のAI社会原則(*2)」が発信され、AIの社会実装を推進するための基本理念や原則が定められました。この原則を基本に、AIの開発や利活用に関するより具体的な指針を示したガイドラインが複数の省庁から提供されています。

荒堀 こういったガイドラインの策定には、より実務的な内容を組み込めるよう事業者が検討に参画するものがあります。富士通株式会社代表取締役社長の時田と私はそれぞれ、総務省主催のAIネットワーク社会推進会議とAIガバナンス検討会に参画し、法規制が検討される前からの当社の先進的な取り組みを、事業者での実践の一例として共有しています。

先ほどの話を聞いて、原則やガイドラインが複数あり、自社が何をどう参照すればよいのか分かりづらいという印象を持った方もおられるのではないでしょうか。その問題に関しては、それらを統合してAIの開発者、提供者、利用者がより参照しやすい形にすべく、事業者向けの統一的なガイドラインの作成が進められています。現在の「AI事業者ガイドライン案」では、AIの開発者、提供者、利用者の立場ごとに取り組むべき対応や責務がまとめられる想定であり、前述したEUのAI規制法案と同様に、リスクの大きさに応じて対策の程度を変えるリスクベースのアプローチとなっています。このガイドライン案は2023年12月に公開されており、2024年3月を目途に正式なガイドラインとして公表される予定です。AIのビジネスに関連するすべての事業者が確認する必要があるものです。

(出所:内閣府HP 「AI戦略会議 第7回」 資料1-2 )

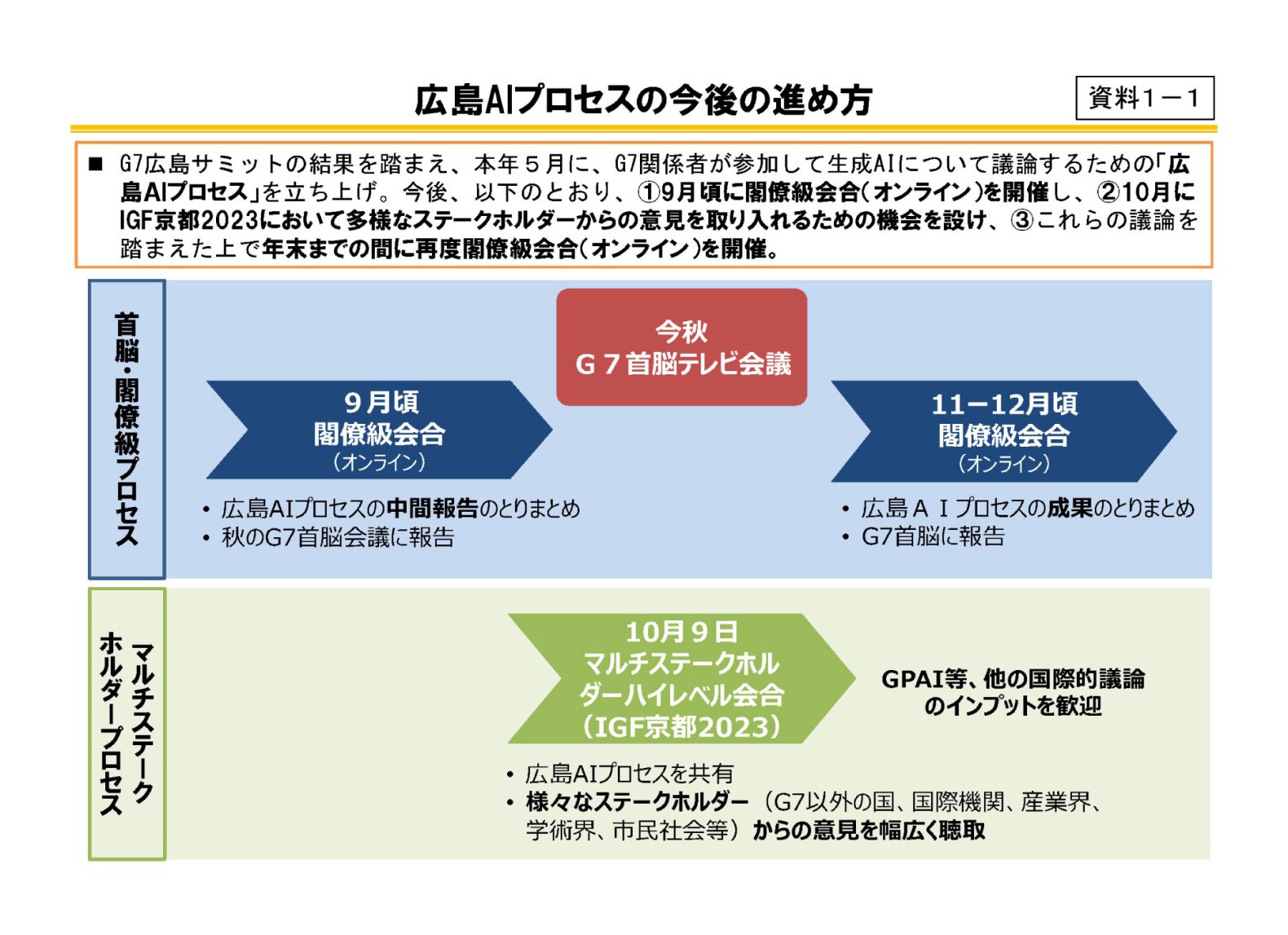

荒堀 これらに加え、直近では「広島AIプロセス(*3)」にも注目すべきでしょう。広島AIプロセスとは、主要7か国(G7)と、OECD(経済協力開発機構)およびGPAI(Global Partnership on Artificial Intelligence)といった国際関係機関が、生成AIの国際的なルールの形成に向けて議論する際の枠組みとなります。これは、2023年5月に開催されたG7広島サミットの結果を踏まえて立ち上げられたものであり、生成AIの利活用や課題、各国の対応状況等を共有し、ガバナンスを形成するためにあらゆる検討が包摂的に進められています。

そして、9月には、広島AIプロセス閣僚級会合が開催され、その議論の結果採択された「G7広島AIプロセス G7デジタル・技術閣僚声明(*4)」には、開発を含むすべてのAI関係者に向けた国際的な指針を年内に策定することが盛り込まれていました。

さらに、10月30日には、G7によって、生成AIリスクへの対策事例を示した「行動規範」への合意がなされました。ここでは、「レッドチーミング(*5)」等の評価方法やAI が生成したコンテンツをユーザーが識別できるようにするための「電子透かし」の導入が例示されています。AI利活用リスクに対する具体的な対応も見えてきているので、企業内での行動指針を検討するうえでは継続したチェックが必要でしょう。

――EUや日本以外の国・地域でも同様の動きが進んでいるのでしょうか?

藤本 他国でもAI規制の動向が見られます。

例えば米国は、企業の自由なAI開発を尊重しつつも、規制は強化する方向で動いています。2022年には大統領府科学技術政策局(OSTP)がAI開発などにあたり考慮すべき原則をまとめた「AI権利章典のための青写真」を発表し、2023年1月には国立標準技術研究所(NIST)がAI技術のリスク管理のためのガイダンス「AIリスクマネジメントフレームワーク(AI RMF)」を発表しました。また、10月末には、米国では初となる法的拘束力を持ったAI規制に関する大統領令を発令しています。一般公開前のAIシステムの安全性を評価するにあたり、厳格な新基準が設定されました。国家安全保障に重大なリスクをもたらすAIの開発企業は、開発過程を政府へ通知し、安全性評価結果を共有することが義務づけられています。AIの適正な利活用の実現に向けた積極的な取り組みが進められているのです。

AIの規制については、法的拘束力を持った規制(ハードロー)を進める国がある一方で、自由な利活用を重視し、法的拘束力はないガイドライン(ソフトロー)で指針を示す国があるなど、各国でアプローチが異なります。各国の方針の下で、企業は自社のビジネス環境を踏まえて、どの法規制やガイドラインに準拠すべきか判断することも求められます。

荒堀 そのような課題の払拭も、広島AIプロセスでの共通ルールに期待されている点です。ここでは国際的指針と、先ほど触れた行動規範が議論されてきました。今後も広島AIプロセスと自社に関連する国・地域の規制動向の双方を注視していく必要があります。

(出所:内閣府 AI戦略会議第4回2023年8月4日 資料1-1)

(*2)内閣官房庁「人間中心のAI 社会原則(統合イノベーション戦略推進会議決定)」

(*3)外務省「G7 広島AIプロセスに関するG7首脳声明」

(*4)総務省「G7広島AIプロセス G7デジタル・技術閣僚声明」

(*5)セキュリティの脆弱性をテストするために敵対者視点から攻撃を行う演習を指す。現在は、従来のサイバーセキュリティ観点の枠を超え、AIシステムの問題点をあぶりだすためのレッドチーミングも増えている。

AI利活用におけるリスクマネジメントに日本企業はどのように取り組んでいくべきか

――とはいえ、現代の企業においてAIの利活用は避けては通れません。様々なリスクや規制がある中で、企業はどのように対応を進めればよいのでしょうか?

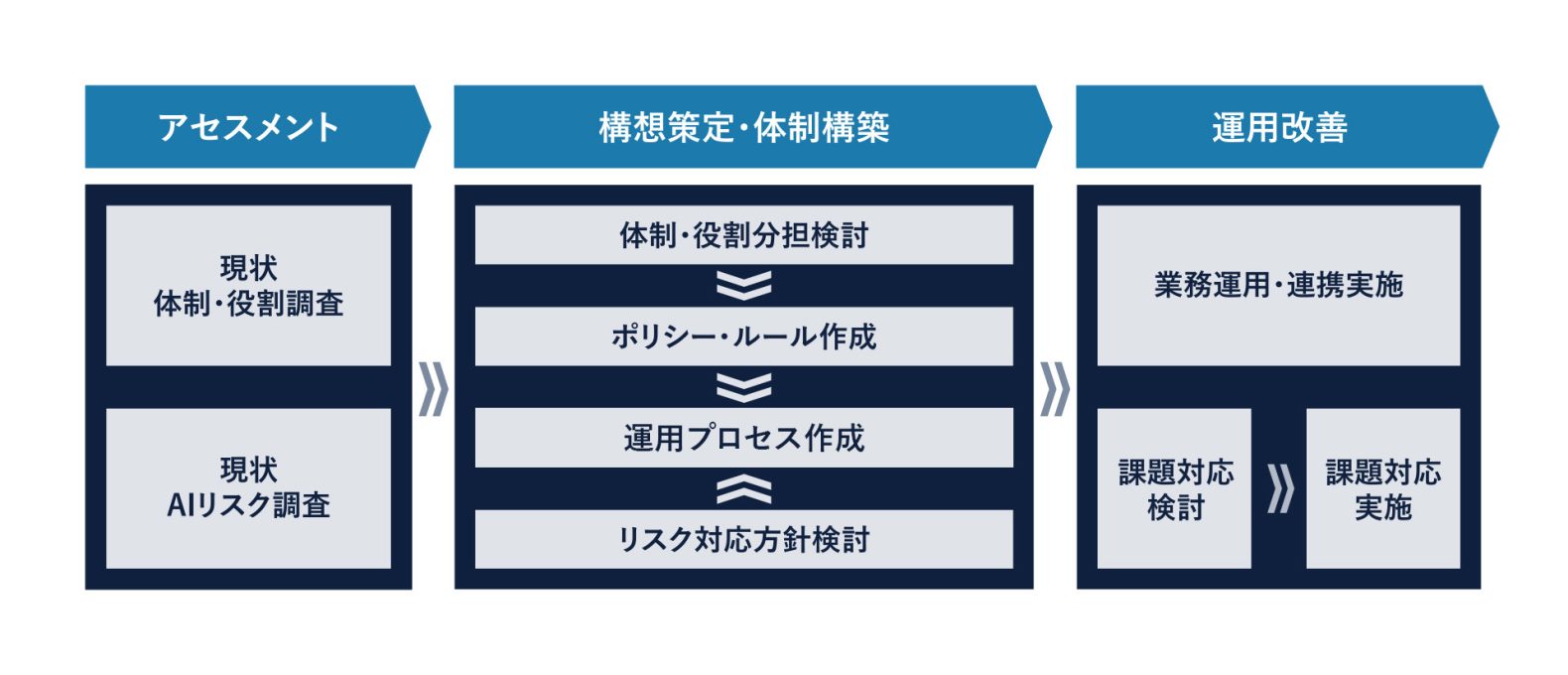

藤本 AIがもたらす利益を最大化しつつ、リスクを最小化するためには、適切なガバナンス体制の構築が不可欠です。具体的にはAIの利活用と管理に関する方針やルールを定め、それらを遵守するための組織体制の整備と定着化が必要です。

まず、自社のAI利活用の現状を把握し、それに基づいてリスクを評価することが第一のステップになるでしょう。社外のAIサービスを利用している、自社でAIを開発している、他社AIを利用したサービスを企画しているなど、自社でどのようなAIがどのように利活用されているかを把握し、それに伴うリスクと影響を評価します。AIにはセキュリティリスクがつきものですので、その評価も欠かすことはできません。

次のステップとしては、評価結果を踏まえたリスク軽減のためのルールやプロセスの策定が挙げられます。最初からルールの完成形を作ることは難しいため、スモールスタートで方針やルールの初版を整備することから始めるとよいでしょう。

荒堀 ルール策定と同時に、倫理規範も示す必要があるでしょう。AIが急速に普及し、社会的影響力が増大しているからこそ、AIの開発や利活用において、人間の尊厳や社会的正義などの倫理的な価値を守ることを徹底しなければなりません。そのために、利活用するAIシステムの公平性や透明性、加えてメカニズムの説明可能性をも確保することが求められます。AIによる不当な差別や侵害、人命に対する脅威などの問題を起こさないようにするために、会社としての指針を示すことは欠かせません。

藤本 定めたルールや倫理規範が遵守されているかを定期的にチェックするモニタリングの仕組みも必要です。モニタリングはある程度の人員が必要となるため、すぐに実施するのは難しい企業も多いと思いますが、継続的なリスク管理体制には中期的な取り組みが必要となることも留意しておくべきです。

――富士通では国内でも早い段階からAI倫理に関する取り組みを進めているそうですね。どのような対応をしていますか?

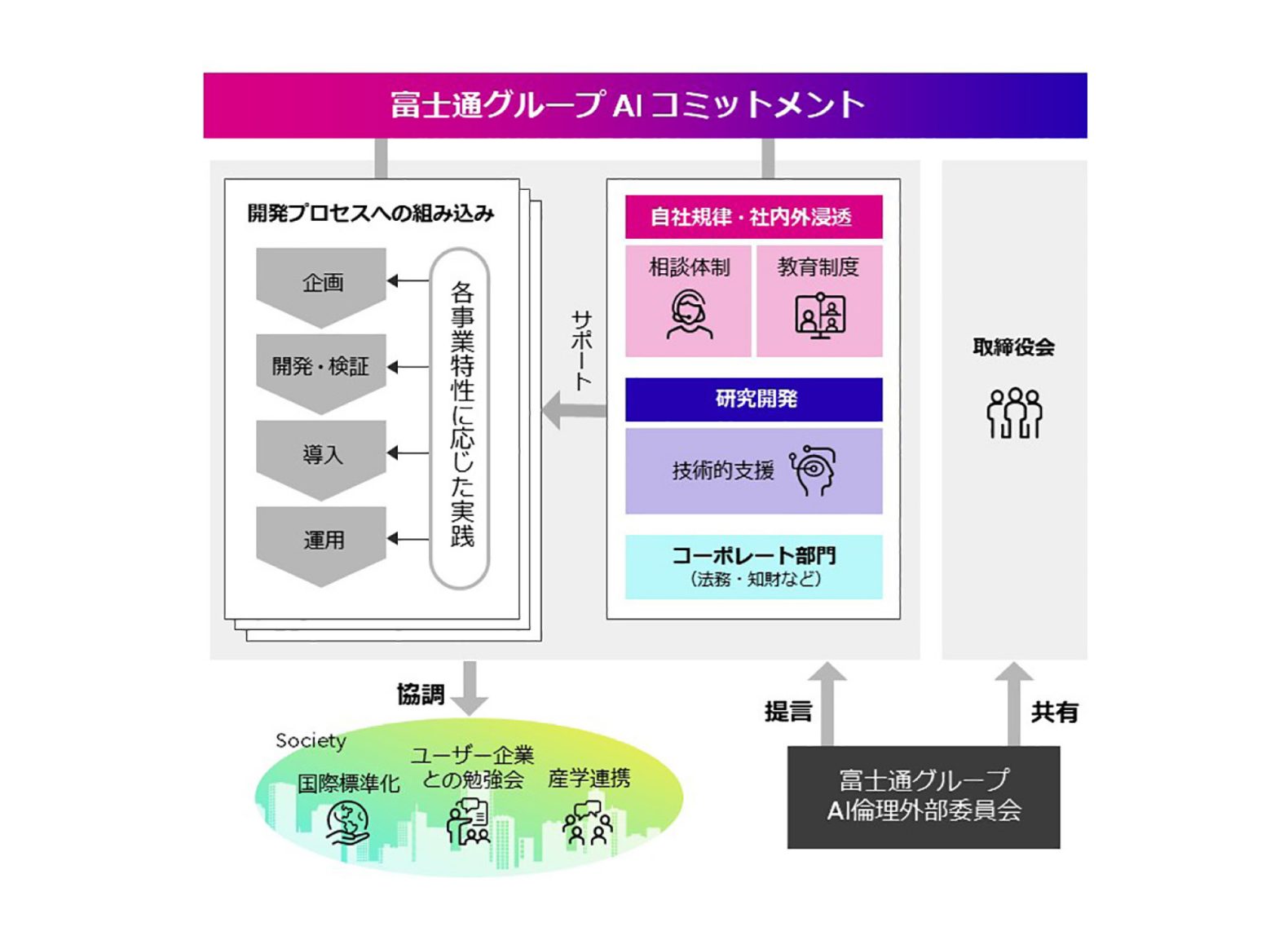

荒堀 富士通は、1985年にAIのためのコンピューター「FACOM α」を商品化して以来、30年以上にわたり日本のAI研究をリードし、現在では国内外にて6,000件以上のAIサービスを提供しています。それらのサービス提供と並行して、富士通のパーパスに掲げられた「信頼」をAI分野でも担保し、「信頼できるAI」を実現するため、AI倫理ガバナンスの取り組みも強化してきました。その中でも特徴的な活動の1つが、2019年に設置された「富士通グループAI倫理外部委員会」です。本委員会は、個別の富士通AIシステムについて審査を実施するといった局所的なものではありません。技術以外にも生命医学、生態学、法学、SDGs、消費者問題など、多様な分野の外部専門家に参画いただき、富士通のAI倫理ガバナンスの取り組みについて客観的な評価をいただいています。その知見を富士通内で活かすことはもちろん、ユーザー企業や社会全体に広げることも視野に入れ、様々な倫理課題や対処法について議論を交わしています。つまり、AI技術に求められる多様性と説明責任について、富士通ではAIガバナンスにおいても体現すべく、組織運営を図っています。

また、実務面においては、ガイドラインの作成や相談窓口の設置、AI倫理チェック機能の構築など、AIの開発から運用まで一貫して倫理を確保するプロセスを確立するための施策に取り組んでいます。

荒堀 加えて、富士通グループ13万人を対象とした、AI倫理の意識向上のための教育も実施しています。AIが身近になり、誰もがこれを利活用してビジネスに取り組む時代なので、会社のルールを決めるだけでは十分ではありません。AIを適切に利活用・管理するためには、従業員一人ひとりがその仕組みや可能性とともに、AIリスクを認識し、AI倫理の重要性を理解する必要があります。これは、AI技術の進展や社会の発展とともに求められる倫理観も変化を伴いますので、従業員がそれぞれAI倫理に対する感度を高め、実践することができる状態を目指す必要があるということです。AIリテラシーの向上を含む人材育成は、AIの可能性を最大限に引き出すために必要不可欠なもののうちの1つでしょう。

――取り組むべきことはたくさんありますが、まず何から進めていくべきでしょうか?

藤本 AIを活用してビジネスの変革を進めるためには、過大なリスク対策が足枷になってはいけません。自社のビジネスやAIの活用シーンを踏まえて、リスクベースアプローチの考え方で、適切なリスクコントロールを設計、実装することが重要です。また、近年の動向では、企業に求められるリスクマネジメントは自社のサプライチェーン全体に対しても注意義務を求めるべきとされる傾向にあります。AIリスクに関しても同様ですので、これを念頭に置いて取り組む必要があります。

荒堀 富士通の様々な取り組みをお伝えしましたが、AI利活用の方法や度合いが企業ごとに異なる状況下で、こういった取り組みのすべてをどの企業でも実施すべきとは、私も考えていません。富士通は先進事例などがない中で、手探りの状態から試行錯誤を繰り返して取り組みを進め、自社に必要かつ適したガバナンス体制を構築してきました。こういった取り組みを1つの参考として捉えていただきながら、企業ごとに必要な対応を取捨選択して進めていただくのがよいと考えています。

藤本 初期の取り組みとしては、前述のとおりAI利活用の現状把握とリスクの可視化から着手することが考えられます。その結果を踏まえて社内ルールを策定し、まずはAIリスクをコントロールできている状態を最初の目標にするのがよいでしょう。そのうえで、管理プロセスの定着化や効率化、さらには予見的対応ができるレベルへのステップアップ、最終的にはビジネス戦略と融合させることで、競争優位を生むためのAIガバナンスに昇華させることが取り組み高度化のシナリオと考えます。

荒堀 富士通は、文化的背景や倫理観も異なるような場所を含め、グローバルに活動しています。提供するAIも汎用的なものから極めて機微な用途のアプリに至るまで幅広い領域にわたっておりますので、本社機能が一律のルールを強制するだけでは盤石なAIガバナンス体制を構築できたとは言えません。各種ビジネスが置かれる条件は異なりますが、その異なる条件に応じてAI利活用に伴うリスクへの適切な対応を実施することが求められるのです。今後の具体的な取り組みとしては、本社機能にて統一的な戦略や指針を明確に指揮する一方で、各部門へ設置されたAI倫理責任者にリージョン特性に合わせたカスタマイズを重視させるなど、AI利活用に伴うリスクへの的確な対応を徹底し、富士通のAIガバナンスへの信頼度を高めていく方針です。

最後に強調させていただきたいのですが、AIガバナンスは、ガイドラインやルールを守るだけでなく、技術や社会状況に応じて変化するリスクへ的確に対応するため、常にそのあり方を見つめなおす組織文化を根付かせることも重要です。したがって、これからも根底にある組織文化を含めたAIガバナンス構築の取り組みは継続的に実施し、発展させていく必要があると考えています。

藤本 これからもAIが進化する中、その利活用如何によっては競争優位の確立を左右することは明らかです。だからこそ、企業には新たなリスクや法規制の強化への適応力が求められます。企業がAIと共存し、持続的に成長していくためには、成長へのアクセルを踏むためのガードレールとしてAIガバナンス体制を構築し、定着させることが不可欠です。Ridgelinezでは、企業ごとのビジネス環境や状況を踏まえたAI利活用のご支援とともにAIガバナンス体制の構築に伴走することで、安心安全なAI利活用の実現と、デジタル時代における企業の成長をご支援します。

共鳴する社会展

共鳴する社会展